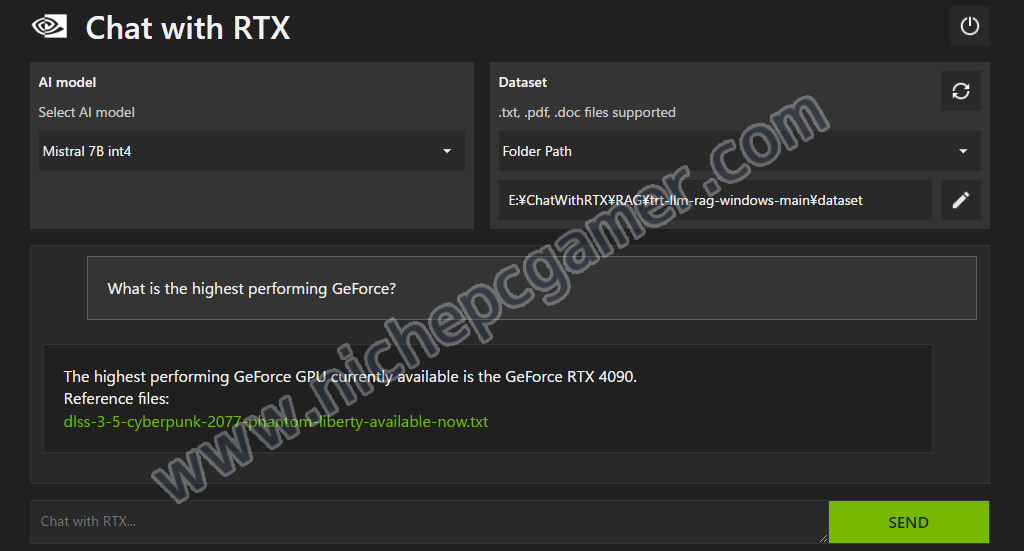

NVIDIA、Chat with RTXを公開。ローカルで動作するAIチャットボット

NVIDIAは、『Chat with RTX』を公開しました。

Chat with RTXとは、ローカルで動作するAIチャットボット。ローカルで動作するため、オフラインでもオンラインでも使用できます。動作環境は以下。

- OS: Windows11

- NVIDIAのサイトにはWindows11のみしか記されていませんが、おそらくはWindows10でも動作するものと思われます

- GPU: 8GB以上のVRAMを搭載したGeForce RTX 3000またはGeForce RTX 4000シリーズ

- 16GB以上のVRAM環境ではLlama 2とMistralの両方をインストールできます。8GBまたは12GB環境ではMistralのみがインストールできます

- メモリ: 16GB以上

- ストレージ: 100GB以上の空き容量。SSDを強く推奨

- 実際には最大70GBほど使用

- ドライバ: 535.11以上

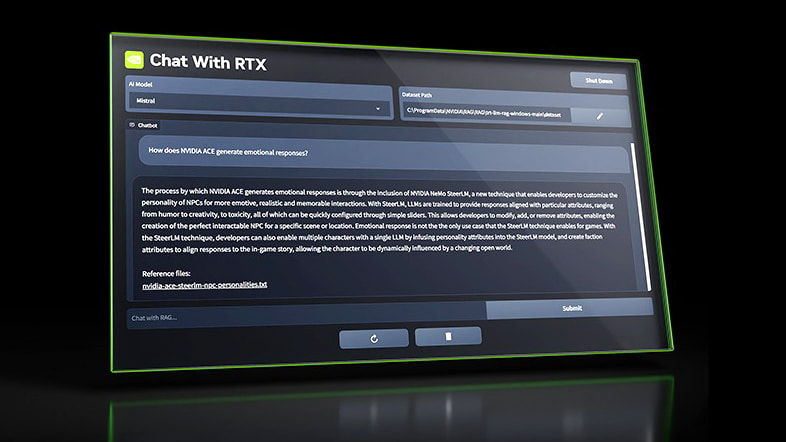

使い方は簡単です。質問を入力してエンターを押すだけです。

上記例では「最も高性能なGeForceは何ですか?」と尋ねたところ、「GeForce RTX 4090」との回答が返ってきました。

また、Chat with RTXは、YouTube動画に対しての質問にも回答できます。ただし、動画の内容を認識・解析しているわけではなく、字幕(Closed Caption / CC)ファイルに基づいて回答されます。

さらに、Chat with RTXは『.txt』『.pdf』『.doc』といったファイルを学習させることもできます。

ただ、残念ながら現時点では英語しか使用できません。使ってみたい方はNVIDIAのサイトよりダウンロードをどうぞ。ファイルサイズは約35GBと非常に大きく、インストールにはかなり時間がかかります。